Deset principů Leidenského manifestu vysvětluje, jak by se (ne)měla používat bibliometrie k hodnocení vědy. Principy nastavují kritické zrcadlo dosavadní české praxi. Přináším další v řadě [1|2|3|4|5] zamyšlení nad šestým principem. Ten hovoří o oborových specifikách a potřebách vhodné standardizace bibliometrických ukazatelů. A kde nestačí nebo není možná standardizace, tam musí nastoupit znalé oko panelistů.

6. Leidenský princip: Je nutné zohledňovat rozdíly mezi obory v publikační a citační praxi. Dobrou praxí je nabídnout jednotlivým oborům soubor možných indikátorů a umožnit jim, aby si z nich vybraly. Před několika lety získala skupina historiků v jedné evropské zemi při národním hodnocení poměrně nízké skóre. Běžně totiž publikovali monografie, nikoli články v časopisech zařazených na Web of Science. Měli tu smůlu, že byli součástí katedry psychologie. Pro historiky a sociální vědce je důležité, aby se mezi jejich výstupy počítaly i monografie a publikace v národním jazyce, pro informatiky jsou to zase příspěvky na konferencích. Počty citací se liší dle oborů: přední matematické časopisy mají impakt faktor kolem 3, cytologické asi 30. Je třeba standardizovat indikátory. Nejspolehlivější metodou je standardizace na základě percentilů: každý článek by měl být hodnocen na základě percentilu, k němuž se řadí v citační distribuci ve svém oboru (například horní 1 %, 10 % nebo 20 %). V žebříčku založeném na percentilních indikátorech zlepší jedna hojně citovaná publikace postavení univerzity jen nepatrně, ale v žebříčku založeném na citačním průměru ji může výrazně posunout ze středních příček k vrcholu.

Ignorování oborových odlišností patří k nejčastějším chybám laických uživatelů bibliometrie. Populární disciplínou bibliometrických neználků bývá poměřování akademického ega hodnotami h-indexů u vědců z různých oborů. Jistě to mnozí znáte i z vaší praxe [1|2]. Srovnávat pomocí bibliometrie cokoliv napříč obory je sice lákavé, ale ošemetné a vyžaduje rozvahu. Pozor, oborem zde nemíním široké oborové skupiny přírodních, technických, společenských, humanitních a medicínských věd. Myslím zde mnohem užší obory jako jsou třeba ekonomie vs. sociologie, počítačové vědy vs. kybernetika, fyzika materiálů vs. fyzika elementárních částic; neurologie vs. endokrinologie. Výrazně se mezioborově liší nejen citační intenzita, ale i průměrné počty spoluautorů připadající na článek, počet článků publikovaných typickým vědcem za rok, praxe (ne)uvádění pořadí autorů a korespondenčních autorů v článcích, (ne)uvádění role autorů v týmech atd.

Jednota vs. specifika

Při plošném počítačovém zpracování bibliometrických přehledů, například pro celou univerzitu nebo fakultu, je obtížné vymyslet jednotné bibliometrické ukazatele a formát šitý na míru každému oboru. Navíc by to vyžadovalo i výrobu speciální dokumentace pro každý obor zvlášť. Jednotné zpracování bibliometrie, bez ohledu na obor, má prostě řadu nepřehlédnutelných výhod na straně zpracovatele i uživatelů. Řešením je proto nechat bibliometrickým přehledům jednotnou podobu a svěřit je s dostatkem informací do rukou oboru a bibliometrie dobře znalých panelistů, ať z toho ty oborové nuance vyčtou. I proto bibliometrie nemůže nahradit hodnotící úsudek lidí z masa a kostí. A pokud to někde zkusí, jako v případě kafemlejnku, tak to neskončí dobře.

Standardizace je když

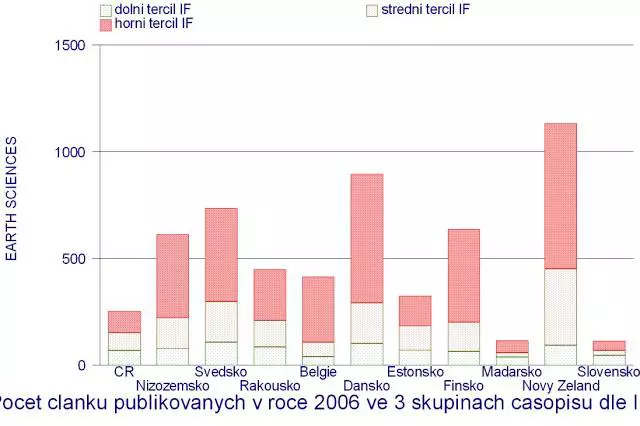

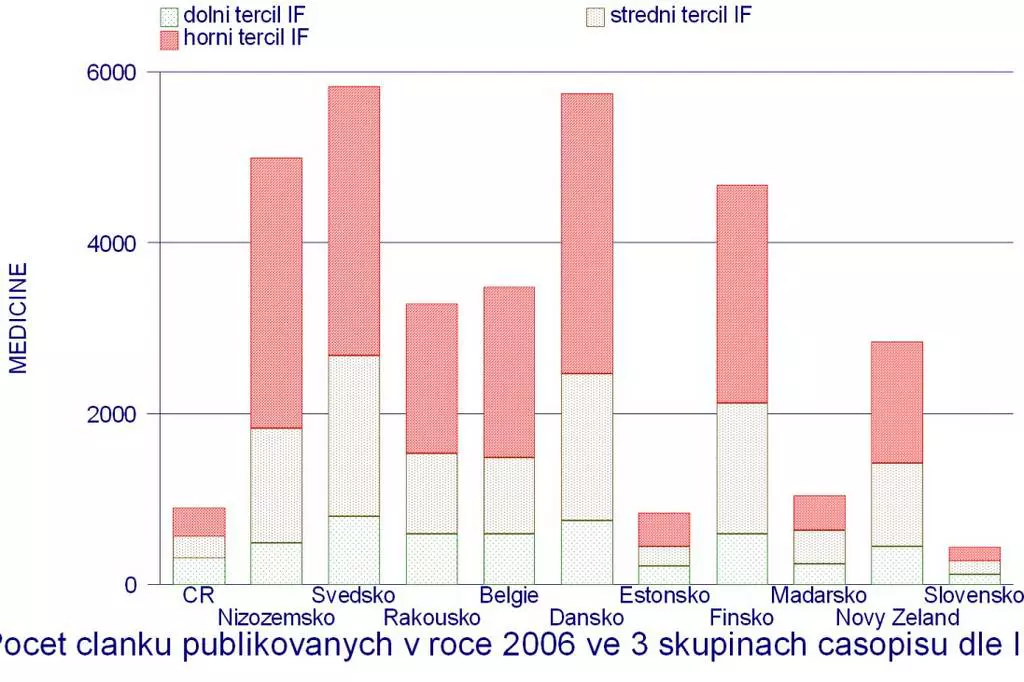

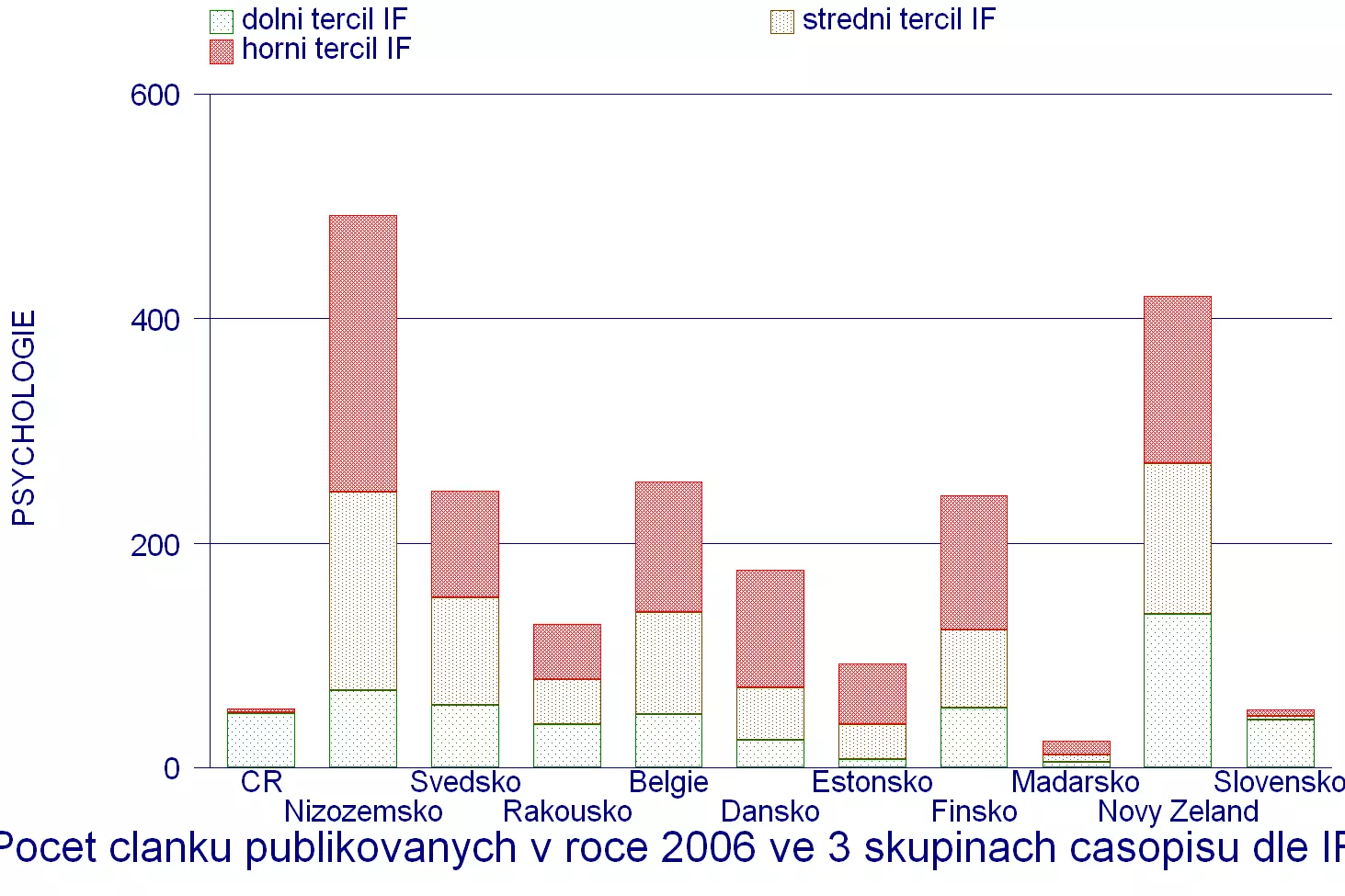

Doporučovanou standardizaci článků na základě percentilů časopisů v rámci oboru jsem začal dělat před dávnými lety. Také jsem kdysi dával rady lidem z Thomson Reuters, tehdejšího vlastníka a provozovatele Web of Science, když se tyto ukazatele v jejich nástrojích ještě nenabízely. Dnes je to již zavedený standard.

V textu 6. Leidenského principu se ale jako příklad uvádí percentily citovanosti článků. Pro hodnocení výzkumných organizací a pracovišť to považuji za problematické, ale z jiných důvodů. Zpravidla totiž chcete hodnotit výkon pracoviště současný nebo nedávný, posledních pár let. V té době ale ještě mnohé citace článků nejsou ještě na světě. Také víme, že není citace jako citace, takže si s pouhým sčítáním citací nevystačíme a musíme sledovat, odkud každá jedna pochází. To ale znamená potřebu spousty dat a času. Pro vytvoření měřítka citovanosti také potřebujete stáhnout obrovské množství článků z jiných zemí či pracovišť. A úplnou tečkou je, že vámi takto náročně stažená data postupem času rychle zastarávají.

I proto je pro potřeby těchto hodnocení lepší pracovat s vědeckým vlivem časopisů, kde články vyšly. Srovnání je potom mnohem snazší, rychlejší, levnější a při vyšším počtu hodnocených článků i dostatečně spolehlivé. Percentilové pořadí se potom týká řazení časopisů v oboru podle výše jejich impakt faktoru nebo AIS faktoru.

Obrovský problém však bývá s posouzením toho, nakolik publikační výkon odpovídá velikosti pracoviště, tedy počtu vědců a objemu finanční podpory. Výpočet publikační produktivity je svým způsobem také standardizace. Příklad: něco jiného je pět v průměru vysoce citovaných článků malého pracoviště než pět stejně průměrně citovaných článků pracoviště obrovského. Srovnat publikační produktivitu je velmi obtížné nejen napříč obory, ale dokonce i v rámci oboru. Podělit počet publikací počtem vědců je velmi ošemetné a navíc přesné informace o počtech vědců v plných ekvivalentech často nemáte kde zjistit. Jediný věrohodný způsob je pak nechat produktivitu posoudit odbornému panelu vědců, kteří prostě vědí, co je v oboru možné a běžné. Nechat tuhle složitou věc na kafemlejnku byla a na některých vysokých školách dosud je hloupostí na kvadrát.

Už z hodně jiného soudku standardizace je příklad uvedený v 6. principu, tedy meziborové rozdíly v typických publikačních kanálech. To už napůl o klasické bibliometrii ani není, protože databáze WoS i Scopus svět monografií pokrývají extrémně nedokonale. Citovanost většiny vědeckých knih zůstává velkou neznámou. A řadit nakladatelství podle citací nejde a nedává smysl.

Další tvrdé oříšky

Vlastně je docela věda, než věrohodný bibliometrický ukazatel dáte dohromady. Když pak jeho smysl lidem vysvětlíte, už to jako velká věda nevypadá. Problém je, když si někdo chce cestu zkrátit a skočí na vějičku nedokonale standardizovaných ukazatelů a nebo si moc nelámou hlavu s jejich možnými či reálnými nedokonalostmi.

Aby mohlo být bibliometrické hodnocení oborové, musí článek na samém počátku do oboru někdo správně zařadit. Když už se náhodu vědci po dlouhém hádání na nějaké oborové taxonomii shodnou, musí se na zařazení konkrétního výsledku shodnout sami jeho autoři. Jenomže citovanost, časopisy atd. nemůžete posuzovat podle oboru, kam je každý jednotlivý autor zařadí svůj článek, ale musíte pracovat s tím, kam časopisy řadí databáze WoS nebo Scopus. Potom se stává, že názor autorů na oborové zařazení nebo obsah článku je v rozporu s oborem zařazení časopisu. Ale třeba i tohle dokáží znalí panelisté rozpoznat a vzít v potaz, samozřejmě pokud mají k ruce potřebné informace.

Pro bibliometrické zpracování jsou těžkým oříškem výsledky mezioborového a víceoborového výzkumu, výzkumu ve velmi specifických a úzkých oborech a v oborech nově se rodících. Při hromadném zpracování bibliometrie pro velká pracoviště se to řeší obtížně. I zde nejlépe poslouží oči znalých panelistů. Dlužno dodat, že tyto druhy výzkumných výsledků to mnohdy nemají snadné u panelistů. Mainstream to má mnohem snadnější.

Mé prehistorické grafy z dob, kdy jsem začal metodu percentilů pro oborová srovnání publikačního výkonu používat [1|2|3].

Autor: Daniel Münich

Text vyšel 22. 7. 2018 na webu metodikahodnoceni.blogspot.com.