Michael Šebek komentuje průběh hodnocení výzkumných organizací podle Metodiky 2017+, které letos prošlo prvním ze tří zahřívacích kol. V minulém díle rozebíral bibliometrické zprávy za obory, které ukazují v jakém oboru je naše země na špičce a v jakém naopak zaostává. V pokračování se zaměřuje na bibliometrické zprávy za organizace a zprávy z peer-review vybraných výsledků.

Bibliometrické zprávy za organizace

Bibliometrické zprávy za organizace prezentují, graficky zpracovávají a komentují několik typů dat. Členění výsledků organizace podle oborové příslušnosti časopisů; rozložení četností a procentních podílů oborově členěných výsledků v prvním decilu a v kvartilech mezinárodního pořadí časopisů dle AIS. Zajímavou novinkou je výpočet oborových mediánů organizace a hlavně jejich srovnání s oborovými mediány národními a světovými.

Srovnání podílů článků organizace se světem v oboru podle kvartilů WoS-AIS časopisu

Tady se Daniel Münich soustředí na kvalitativní publikační profily organizace a já to udělám také. Dan na nich kritizuje hlavně to, že není nijak explicitně zahrnuta „velikost pracoviště“, měřena třeba počtem úvazku v konkrétním oboru nebo institucionálními příjmy na obor. Podle mne je to nesmysl a právě u publikačních profilů nehraje velikost pracoviště skoro žádnou roli! Pokud profil zahrnuje dostatečný počet publikací, aby se šíleně neměnil z roku na rok, aby nebyl téměř náhodný, pak už na velikosti pracoviště nezáleží vůbec?! Pokud má pracoviště naprostou většinu svých článků ve špičkových časopisech (nebo naopak v těch nejhorších), pak je prostě špičkové (nebo naopak špatné), ať už má zaměstnanců padesát nebo pět set!?

Počty špičkových a výborných publikací organizace v oboru

Naopak „velikost“ musíme vzít v úvahu, porovnáváme-li různá pracoviště podle absolutního počtu nějakých publikací (v D1, Q1 nebo třeba v Q4)! A hodnotíme-li jejich podíl na počtu těchto publikací v ČR. Jelikož Úřad vlády informaci o „velkosti pracovišť v oboru“ nemá, ponechává to zatím Metodika vágně na panelech - odborníci přece tuší, které pracoviště je v oboru velké či malé. Ostatně také proto se informace o podílu organizace na článcích v D1 a Q1 v ČR zatím raději nedávala do zpráv za jednotlivé organizace.

Velikost organizace v daném oboru oficiálně neznáme

Metodika 17+ zatím s „velikostí organizací“ nepracuje prostě proto, že ji nezná! Oficiálně ji totiž v této zemi nezná nikdo! Tak proč to Dan vyčítá Metodice? Jakmile zřizovatelé/organizace/kdokoli jiný vymyslí a oficiálně schválí metodu, jak určit velikost pracoviště, Metodika 17+ ji ráda použije.

Vždyť ani organizace samy neznají počet svých tvůrčích pracovníků a rády si s ním hrají. Jednou se tváří jako velké, jindy jako malé, jak se jim to hodí. Kdysi mne překvapil výsledek jedné školy v mezinárodním žebříčku a tak jsem zkoušel zjistit počet jejich akademiků. Ve výroční zprávě měli akademiků hodně, navenek je přece dobré vypadat velcí. Ale do toho žebříčku udali počet menší, zhruba poloviční. Tam se totiž hodilo být malí, protože počtem lidí se počet citací dělil!

Porovnání oborových mediánů organizace a jejich srovnání s mediány národními a světovými

Tak tohle Dan považuje za „zbytečné až zavádějící“, aniž by nějak vysvětlil, proč. Pro mne je to údaj důležitý. Přece se hodí vědět, jestli je organice v oboru podle článků před nebo za světovým mediánem? A v jaké poměru? Pokud ještě porovnáme medián národní, můžeme třeba zjistit, že i národní lídr je pořád ještě za světem pozadu, prostě proto, že je u nás za světem pozadu celý obor. Nebo že je sice obor celkově pozadu, ale přesto některá česká organizace svět předhání.

Zprávy z peer-review vybraných 'nebibliometrizovatelných' výsledků

Hodnocení vybraných výsledků probíhalo v ČR na celostátní úrovni vlastně poprvé (pomineme-li malý pokus v Pilíři II Metodiky minulé). Postup byl tento: Každá organizace musela k posouzení zaslat právě 10 % z 'nebibliometrizovatelných' výsledků, které v roce 2016 měla a „uplatnila“ v databázi RIV, minimálně však 10 ks. V oborové struktuře odpovídající struktuře všem 100 %. A to právě těch, které sama považuje za nejlepší - tedy mohla si je sama vybrat. Ty pak za pomoci vzdálených hodnotitelů posoudil příslušný odborný Panel. Nakonec dostal každý výsledek známku „jedna“ až „pět,“ jako ve škole. Definice známek jsou poměrně přesné a výstižné, určitě si je přečtěte podrobně. Tak třeba trojka je dobrá známka, znamenající buď „výsledek, který je z hlediska originality, významu a obtížnosti získání mezinárodně uznávaný,“ nikoli však špičkový ani vynikající. Anebo „výsledek na velmi dobré úrovni, jehož využití v praxi přinese změnu s ekonomickým dopadem na českém trhu nebo změnu s dopadem na společnost“, nikoli však mezinárodní.

Aplikační výsledky byly celostátně hodnoceny vůbec poprvé

Nebibliometrizovatelné výsledky jsou hlavně ty nepublikační, v mnoha případech zvané aplikační. Přivést něco do života, vyrobit a prodat, použít a využít ku prospěchu lidí, to opravdu není snadné. Aplikačnímu výsledku lze proto odpustit mnohé – až na to hlavní: Aplikačnímu výsledku nelze odpustit, když vůbec není aplikován, když nikomu neslouží! Aplikační výsledek bez aplikace se prostě minul účelem a cílem. Ne vždy se aplikace povede, to je jasné. Úplná zbytečnost a nesmysl je ale aplikační výsledek, který se nikdo aplikovat ani nepokusil. Jak se dnes ukazuje, právě takových – aplikačně neaplikačních - výsledků máme hodně, jenom jsme o tom „nevěděli.“ Peer-review takových výsledků v našem státě dosud chybělo.

Je vlastně dost šokující, že Kafemlejnek nezajímalo, co všechno vlastně v této kategorii sečítá. Úplně stejně odměňoval vynález s dopadem na celý svět, vynález bez jediného výrobku, „vynález“ okopírovaný odjinud a dokonce i naprostý nesmysl, který nikdy nefungoval a snad ani neexistoval. Prostě to nikdy nikdo nezkoumal! A ještě navíc, množit nesmysly je snadné a často bezpracné. Metodou copy-paste můžete například užitné vzory množit jak na běžícím páse, jejich originalita ani funkčnost totiž zákon nezajímá. Proto tak hromadně rostly právě počty nepublikačních výsledků. A k tomu ještě mnozí kolegové, zejména z technických věd, do omrzení opakovali, „že důležitější než články jsou právě výsledky aplikační a nebibliometrizovatelné, které právě oni produkují.“ Možná ano, možná ne. Dosud to nikdo nevěděl a nezkoumal. Ale teď to víme, jak to je - právě díky změně Kafemlejnku na Metodiku 17+! Některá zjištění jsou zjevná už po prvním běhu:

Dva profily známek vybraných výsledků jako příklad

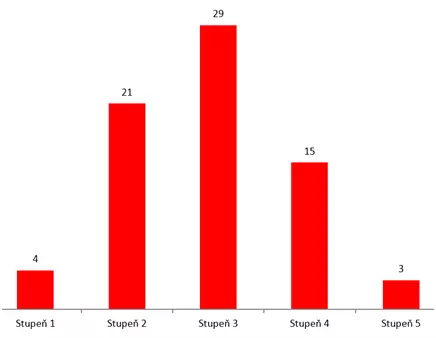

Za zhruba 70 zaslaných výsledků dostala jedna organizace známky v následujícím rozložení:

Zhodnocení ponechám na čtenáři. Na první pohled vypadá graf dost dobře. Problém je v tom, že tohle jsou výsledky, kterými se organizace pochlubila. To je těch nejlepších 10%. Zbývajících 90%, zde zhruba 630, jsou téměř jistě na pětku. Jinak by přece vybrali je?

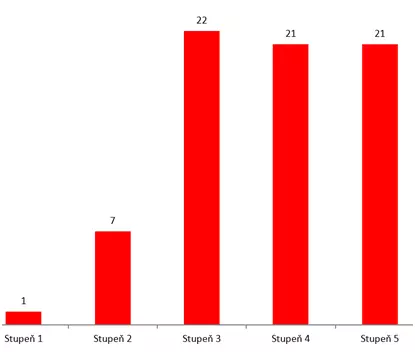

A může být ještě hůř! Druhá organizace zaslala ve stejné skupině oborů 72 výsledků a dostala za ně tyto známky:

Tady už i mezi nejlepšími 10 % tvoří špatné výsledky většinu. A k tomu těch zbylých 630 ještě horších?

Máme horší články nebo aplikace? Obojí!

Tohle jsou jen příklady, ve kterých míchám obory dohromady. Kromě toho nebyl první běh hodnocení moc dobře kalibrován. Přesto i tak dávají obrázky celkem jasnou zprávu o tom, že velká většina nebibliometrizovatelných (aplikačních) výsledků těchto organizací asi za moc nestojí. A musím znovu opakovat: V době Kafemlejnku jsme tohle oficiálně nevedli, protože Kafemlejnek dovnitř nekoukal! U mnoha oborů a organizací, které o sobě dlouho tvrdily, že mají články špatné jen proto, že se oni soustředí na aplikace, poprvé jasně vidíme, jak to je doopravdy. Že jejich aplikace jsou mnohdy ještě horší než jejich články. Až teď o tom můžeme začít přemýšlet a jednat. Jen díky Metodice 17+!

A nyní zpět k Danovu článku. Ten hodnocení vybraných výsledků vcelku chválí, ale i tak musím některá jeho tvrzení uvést na pravou míru.

Dvě kritéria

Tak třeba ve větě „Navíc se hodnotila pouze společenská relevance výsledků (komerční nebo společenské užitečnosti), nikoliv vědecký přínos.“ můžeme rozumět různě. Přesněji je to takto: Když instituce vybírá ze svých vlastních výsledků ty nejlepší, u každého z nich si může vybrat jedno ze dvou kritérií pro budoucí posouzení: Buď společenskou relevanci, anebo přínos poznání. Buď jedno, nebo druhé. Nikoli obě současně. Přesně tak to bylo a organizace tak výsledky vybíraly, zdůvodňovaly a zasílaly. Z praktických důvodů se v prvním roce zhodnotily jen ty výsledky, u kterých instituce vybraly to první kritérium. Zbytek už zaslaných výsledků (ty s kritériem druhým) bude prostě zhodnocen až ve druhém běhu, společně se všemi výsledky za další rok. Tím žádná škoda nevznikla, jen malé zdržení u části zaslaných výsledků.

Je 10 % hodně nebo málo?

Dále Dan kritizuje, že bylo zhodnoceno málo výsledků „ 1500, což je dost málo na celou Českou republiku, kde působí více než stovka výzkumných organizací a kde v roce 2016 vznikly desítky tisíc vědeckých výsledků.“ I tady musím odporovat, protože tak to prostě není! Ve skutečnosti byly zhodnoceny úplně všechny nebibliometrizovatelné výsledky z roku 2016 v RIV (s malou výjimkou zmíněnou dále). Nejprve totiž každá výzkumná organizace posoudila všechny své výsledky sama a vybral z nich ty nejlepší. Organizace mohla a měla procesu výběru svých nejlepších výsledků využít k vnitřní veřejné diskusi o kvalitě a ke kultivaci vlastního tvůrčího prostředí! No a ty nejlepší, tu smetanu doma sebranou (vlastně vybranou) tu pak nechala posoudit Panelům. A neříkejte mi, že snad některá organizace vybrala špatně a pochlubila se výsledky špatnými! Pokud se to stalo, není to vina Metodiky, ale vedení té organizace. Neměly by se pak její šéfové vyměnit, když ani neví, co mají doma nejlepší? Jak asi organizaci řídí a rozdělují peníze uvnitř?

Dan ještě pokračuje „Nízká kvóta počtu výsledků založená na počtu čárek organizací v opuštěném Kafemlejnku však nedala dobrým pracovištím možnost ukázat vše dobré, co mají“ a dokládá to odkazem na tabulku s jednotkami výsledků. Jenže tohle tvrzení je pochybné a přiložená tabulka dokonce scestná! Neukazuje totiž počty zaslaných publikací, ale jen počty těch nejlepších mezi nimi, jen počty jedničkářů a dvojkařů! Například jedno v oborech tabulky veliké pracoviště ve skutečnosti zaslalo výsledků 73, tedy až dost – no vlastně až příliš mnoho! Oznámkovány byly následovně: žádná jednička a jen jedna dvojka, to je právě ta v tabulce. A potom 10 trojek, 13 čtyřek a 12 pětek. S velkou jistotou můžeme předpokládat, že všechny ostatní by také dostaly pětku, a proto vybrány nebyly. Tak proč se s nimi zabývat? A pokud náhodou organizace vybrala špatně, tak ať si udělají pořádek doma. Ani jiné pracoviště – dost malé – nezaslalo jen jeden výsledek, jak by se z tabulky zdálo. Ve skutečnosti zaslalo 3. Z nich jeden dostal dvojku (ten je v tabulce). Zbylé mají trojku a do tabulky se nedostaly. Takže těch dalších asi 27 výsledků, které zaslány nebyly, bylo tak na trojku či horší. To špatné určitě není, ale k chlubení mi to také nepřijde. Nejlepšího průměru z vybraných – ve stylu britského REF – by zřejmě i ty nejlepší dosáhly zasláním výsledku jediného! Proč tedy počet vybraných výsledků ještě nafukovat?

Na druhou stranu, a v tom se s Danem shodneme, bylo těch 10 % výsledků dost na to, aby „přinutilo špatné organizace, zaměřené na nekvalitní kvantitu, odhalit karty." Takže se zpětně dozvíme, jen díky autorům Metodiky 17+, kdopak to v Kafemlejnku opravdu přeháněl.

Závěr

Na to, že byl jen zahřívací a ladicí, ukázal toho první běh hodnocení podle Metodiky 17+ opravdu dost. Dost na to, aby se zvedla vlna odporu těch, kteří se chtějí vrátit do přítmí Kafemlejnku. Nesmí se jim to podařit v žádné formě, jinak by naše země i naše univerzity ve světových srovnáních stále upadaly!

Autor: Michael Šebek

První díl blogu, ve kterém se Michael Šebek blíže věnuje bibliometrickým zprávám za obory, naleznete zde.